DAMIAN CZEKAJ: W takie gorące dni jak ten, w którym rozmawiamy, częściej niż zwykle szukamy informacji o pogodzie. Wskazałby pan jedno miejsce, gdzie warto zajrzeć?

MARIUSZ FIGURSKI: Zdecydowanie na przygotowany przez CMM „Portal letni”. Jest to serwis analogiczny do „Portalu zimowego” dostępnego w okresie zimnym na stronie CMM modele.imgw.pl.

Co znajdziemy w „Portalu letnim”?

Umieściliśmy w nim szereg produktów mogących zainteresować przeciętnego użytkownika. Spośród wielu produktów najnowszym jest system nowcastingowy, czyli prognoz ultrakrótkoterminowych, MeteoWarn, który ostrzega przed różnymi zjawiskami ekstremalnymi, m.in. opadami gradu, wyładowaniami atmosferycznymi, dużymi porywami wiatru. Jest on niezwykle precyzyjny, od chwili uruchomienia możemy w zasadzie mówić o pełnej sprawdzalności, ale ograniczony czasowo – podaje ostrzeżenia na godzinę/dwie przed wystąpieniem niebezpiecznych zjawisk. Ktoś mógłby powiedzieć, że to bardzo mało. Jednak nawet w ciągu godziny można podjąć działania, które pozwolą uniknąć ofiar śmiertelnych czy ograniczyć straty materialne. Oczywiście IMGW wydaje też ostrzeżenia z dłuższym horyzontem czasu, tzw. synoptyczne, ale im późniejszego okresu dotyczą, tym ich sprawdzalność maleje.

Ponadto w „Portalu letnim” przygotowaliśmy specjalne wizualizacje prezentujące podstawowe pola meteorologiczne, takie jak temperatura, wiatr czy temperatura odczuwalna, gdyż w naszym zespole mamy też specjalistów od biometeorologii. Wśród produktów są także prognozy długoterminowe, które cieszą się dużym zainteresowaniem szczególnie w okresie urlopowym.

Wszystkich tych prognoz, o których już pan wspomniał, nie byłoby bez odpowiednich modeli. Jak wygląda ich przygotowanie?

Samo uruchomienie modelu regionalnego, z którymi zazwyczaj mamy do czynienia w CMM, nie jest trudne. Problemem jest, aby symulacje numeryczne faktycznie odwzorowywały rzeczywiste warunki, które występują na danym obszarze. Kiedyś porównałem modelowanie do operacji na otwartym sercu. Dlaczego? Bo wraz z postępującą zmianą klimatu obserwujemy coraz więcej zjawisk ekstremalnych o złożonej fizyce, a do tego dochodzą nowe dane o obserwowanych zjawiskach, dlatego musimy udoskonalać modele, wprowadzając nowe parametryzacje zjawisk zachodzących w różnych skalach przestrzennych i czasowych. Aby model prawidłowo odwzorowywał warunki panujące za oknem, niejednokrotnie musimy modyfikować setki parametrów związanych z dynamiką czy fizyką atmosfery. To niezwykle skomplikowane. Można powiedzieć, że modele są cały czas „rozbebeszone” i na bieżąco wprowadzamy do nich poprawki wraz z napływem nowych danych i postępem wiedzy w zakresie fizyki modelowanego zjawiska.

Co jest potrzebne do uruchomienia modelu regionalnego?

Dwie rzeczy: model globalny, który nam zdefiniuje warunki początkowe i brzegowe, oraz dane obserwacyjne. My w zasadzie korzystamy z czterech podstawowych modeli globalnych: europejskiego IFS z ECMWF [Europejskie Centrum Średnioterminowych Prognoz Pogody – red.], amerykańskiego GFS, francuskiego ALARO i niemieckiego ICON. Dlaczego aż z kilku? Ponieważ każdy z nich ma swoje wady i zalety. Mocno upraszczając, w zależności od sytuacji synoptycznej jeden może lepiej prognozować opady, inny – temperaturę.

Nie ma polskich modeli globalnych?

Ze względu na stopień skomplikowania tego typu modele budowane są i rozwijane w konsorcjach międzynarodowych, bo żaden kraj samodzielnie by sobie z tym nie poradził. IMGW-PIB jest członkiem niektórych z tych konsorcjów, jak COSMO czy RC LACE. Ponadto uczestniczymy obecnie w wielkim projekcie koordynowanym przez ECMWF pod nazwą „Destination Earth”, którego celem jest stworzenie cyfrowego bliźniaka Ziemi. Nasz Instytut w ramach tego przedsięwzięcia bierze udział w opracowaniu założeń i budowie nowego modelu dla Europy. Tak więc współpracujemy z wieloma jednostkami, głównie z Europy, ale nie tylko. Z instytucji spoza naszego kontynentu warto wymienić amerykańską agencję NOAA – chyba największą jednostkę meteorologiczną na świecie.

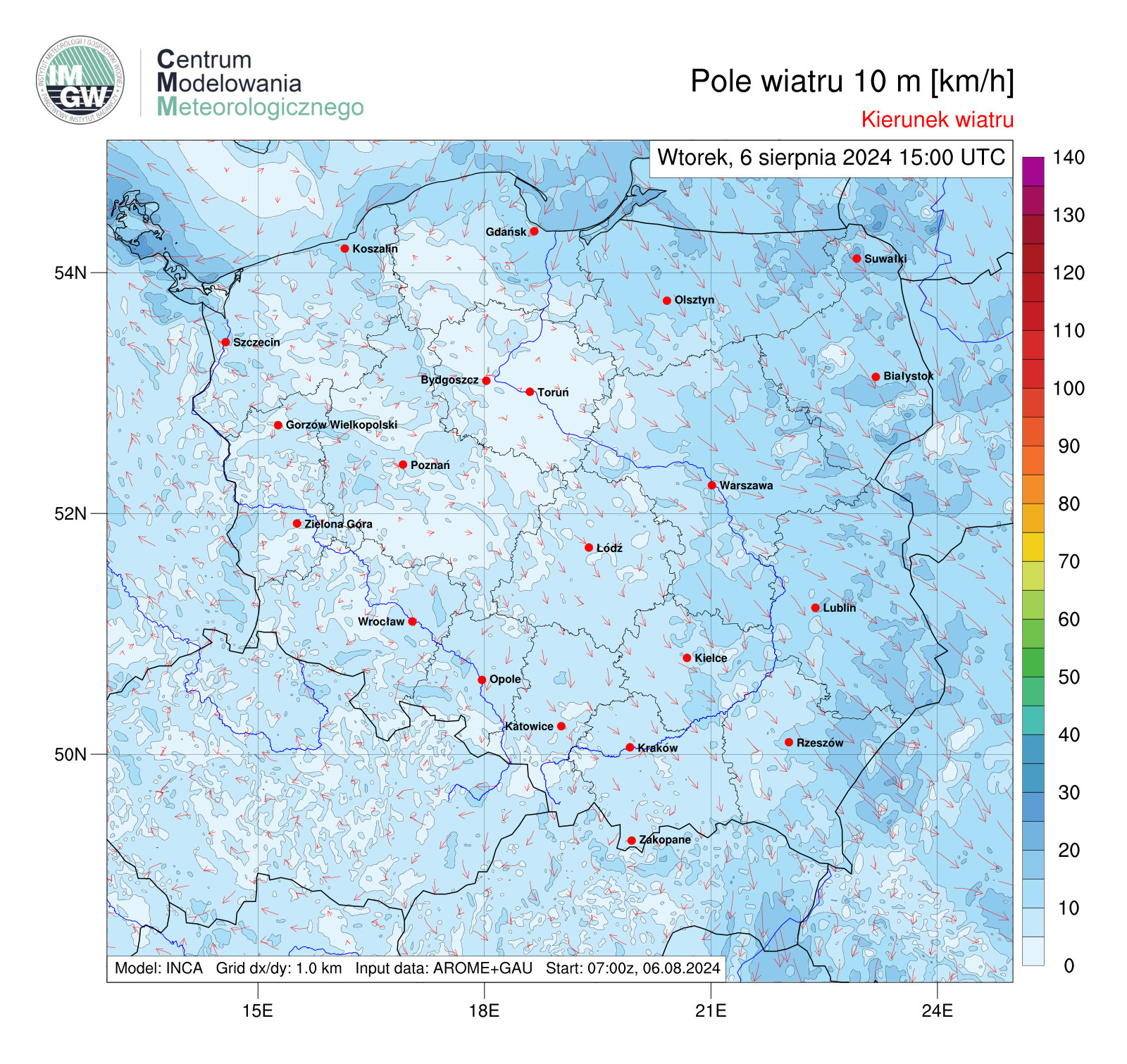

Prognoza ultra-krótkoterminowa – wiatr

Prognoza ultra-krótkoterminowa – wiatr

A jak wygląda sprawa z obserwacjami?

Aby model dobrze działał, konieczne jest zasilenie go danymi w procesie tzw. asymilacji danych pomiarowych. I to jest chyba największa pięta achillesowa wszystkich modeli. Problem bowiem nie tkwi w pozyskiwaniu danych (przykładowo IMGW wykorzystuje dane zarówno ze swojej sieci stacji, jak i światowych baz danych meteorologicznych), ale w ich szybkim włączaniu do modelu, z reguły w czasie dwóch godzin. Stąd też największe instytucje meteorologiczne na świecie, jak NOAA czy ECMWF, mają własne wydzielone sieci przesyłania danych, wydzierżawiają łącza światłowodowe czy satelitarne. Proszę sobie wyobrazić – przesłać dane z całego świata w ciągu dwóch godzin. To jest wyzwanie.

Obecnie dużo się mówi o big data, a my to już mamy od wielu lat. Do modeli asymilowane są dane pochodzące z różnych sensorów i urządzeń pomiarowych satelitarnych, naziemnych sondowań aerologicznych, GNSS i wielu innych. Ktoś policzył, że dziennie zbiera się ich około petabajt. I te dane muszą trafić do modelu, a jeszcze wcześniej przejść weryfikację, za którą odpowiadają specjalne systemy diagnostyczne.

Mimo to nie sposób uniknąć błędów.

Wszystkie otrzymane rozwiązania są obarczone pewnym błędem. W przypadku modeli deterministycznych przy danych warunkach początkowych otrzymujemy jedną symulację przyszłych warunków meteorologicznych, czyli jeden scenariusz pogody. Natomiast w przypadku deterministycznych modeli mezoskalowych, czyli regionalnych, wyniki obliczeń będą zależały od warunków początkowych oraz od warunków brzegowych otrzymanych z modelu globalnego. Jeżeli wystąpią błędy w modelu globalnym lub błędy pomiarowe, na końcu otrzymamy również błędną symulację.

I nic nie można na to poradzić?

Pewnym obejściem procesów deterministycznych, które stosujemy, są tzw. prognozy wiązkowe, które pozwalają wprowadzić element losowości w prognozach. Metoda prognoz wiązkowych w pewnym sensie minimalizuje niedoskonałości modelu. To w dalszym ciągu jeszcze novum, które pozwala uzyskać prawdopodobieństwo wystąpienia otrzymanego wyniku. W tym celu uruchamia się 10, 20 czy nawet 100 wersji modelu jednocześnie. Z tym że warunki początkowe każdej z tych wersji zostają w odpowiedni sposób zaburzone. Ponadto elementy wiązki można otrzymać przez zastosowanie różnej fizyki (różne parametryzacje tego samego zjawiska) lub różnych schematów numerycznych.

Na końcu otrzymujemy wiązkę różnych scenariuszy przyszłej pogody. W oparciu o otrzymane symulacje można wyznaczyć średnią po zespole, rozrzut w wiązce, czyli tzw. spread, a także prawdopodobieństwo przekroczenia pewnych progów, np. temperatury powietrza powyżej 30°C za pięć dni. Jak pokazują badania, średnia po zespole jest bardziej zbliżona do rzeczywistości niż przebieg deterministyczny. Dla synoptyków to niezwykle cenne narzędzie.

Mimo to nadal występują problemy ze zjawiskami ekstremalnymi i wciąż pracujemy nad tym, aby zwiększyć czułość modeli na te zjawiska. Główna trudność polega na tym, że zjawiska ekstremalne, które zachodzą w Polsce, są małoskalowe i wymagają modeli o rozdzielczości przestrzennej na poziomie kilkuset metrów.

Zatem konieczne staje się zwiększanie rozdzielczości modeli.

Zgadza się, jest to obecnie jeden ze światowych trendów w meteorologii. Te modele, które najczęściej spotykamy w Internecie, mają rozdzielczość przestrzenną na poziomie kilku kilometrów. Ta rozdzielczość to długość boku pojedynczej kostki, dla której dany parametr przyjmuje jedną wartość, w trójwymiarowej siatce gridowej modelu. W przypadku temperatury, która jest polem ciągłym, te kilka kilometrów jest jeszcze do zaakceptowania, ale w przypadku pól dyskretnych, jak opady, może dojść do sytuacji, w której deszcz w rzeczywistości pada tylko w rogu kostki, a zostaje rozciągnięty na całą jej objętość. Jest to szczególnie problematyczne na terenach górskich, gdzie pogoda w miejscach oddalonych od siebie o zaledwie kilka kilometrów może się diametralnie różnić.

Żeby to obejść, trzeba zwiększyć rozdzielczość. I dlatego eksperymentalnie, współpracując z Centrum Informatycznym Trójmiejskiej Akademickiej Sieci Komputerowej w Gdańsku, na ich superkomputerach opracowałem model WRF o rozdzielczości 500 metrów. Jest on dostępny na „Portalu letnim” i obejmuje trzy obszary: Tatry i Podhale, Wielkie Jeziora Mazurskie oraz Trójmiasto z Zatoką Gdańską. Prawdopodobnie w przyszłym roku uruchomimy podobny model dla całej Polski, może nie o rozdzielczości 500 metrów, ale na pewno przynajmniej kilometrowy. Obecnie trwa konfiguracja naszych nowych superkomputerów, która powinna zakończyć się pod koniec roku, więc będziemy mieli więcej mocy obliczeniowej.

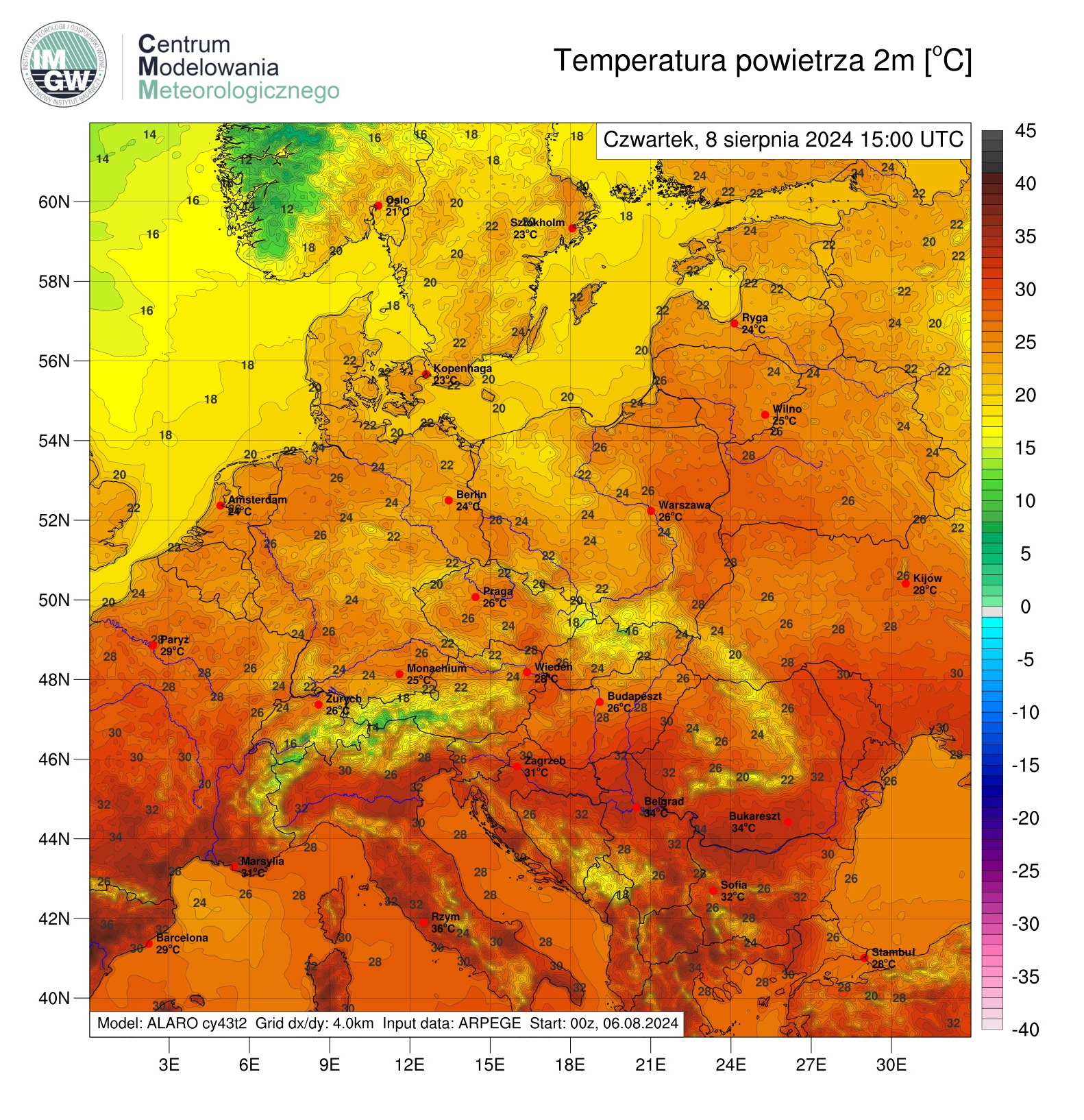

Prognoza krótkoterminowa – temperatura

Prognoza krótkoterminowa – temperatura

Czy wszystkie wykorzystywane modele to współczesne opracowania?

Nie, część powstała przeszło 30 lat temu i została napisana w Fortranie. Dziś już trudno znaleźć specjalistów informatyków od tego języka, dlatego nikt nie myśli o przepisywaniu milionów linii kodu na nowy język, tylko rozwija się modele bazujące na tym języku poprzez samokształcenie. Zresztą nawet nie ma takiej potrzeby – niemała liczba wielkich systemów obliczeniowych wciąż bazuje na Fortranie. Poza tym nie ma pewności, czy przepisany model dawałby te same poprawne wyniki co stary. Należy bowiem zdawać sobie sprawę z tego, że błędy w modelach mogą mieć wiele źródeł, np. dobór długości słów maszynowych. Powiem więcej – ten sam model o tej samej konfiguracji uruchomiony na różnych klastrach obliczeniowych może dać odrobinę inne wyniki. Dlatego też nim model pójdzie do produkcji, jest przez wiele miesięcy testowany, aby wyniki po przeniesieniu były zgodne.

CMM, którego jest pan dyrektorem, powstało 1 stycznia 2021 r. Jak pan wspomina te lata?

Kiedy kilka lat temu rozpoczynałem pracę w IMGW, modelowanie meteorologiczne było rozrzucone po różnych komórkach Instytutu. Funkcjonowały wówczas dwa zespoły modelowania mezoskalowego COSMO i ALADIN zajmujące się prognozami na kilka dni, a także zespół nowcastingu – specjalizujący się w prognozach ultrakrótkoterminowych, z reguły do 8 godzin, o wysokiej dokładności. Później zorganizowałem jeszcze jeden – Zakład Prognoz Długoterminowych i Analiz Meteorologicznych, czyli skupiający na prognozach miesięcznych i sezonowych. Ostatecznie udało mi się zintegrować te wszystkie grupy i 1 stycznia 2021 r. powstało Centrum Modelowania Meteorologicznego IMGW-PIB, którego zostałem dyrektorem. Naszym mottem, jeżeli chodzi o CMM, stało się hasło „Prognozy profilowane pod użytkownika”. Chcemy bowiem dostarczać nie takich prognoz, które można znaleźć wszędzie w Internecie, ale takich, których oczekują konkretni odbiorcy.

Uruchomiliśmy własne kanały komunikacyjne w mediach społecznościowych, zbudowaliśmy własną stronę. Jako CMM jesteśmy więc w pewien sposób samowystarczalni. W zasadzie dysponujemy całą linią technologiczną – od pozyskiwania danych, poprzez modelowanie, analizy i publikację. Dzięki temu możemy bardzo szybko reagować na różnego rodzaju zdarzenia i dostarczać analiz bazujących na prognozach pogody profilowanym odbiorcom. Mam tu na myśli zarówno ogólnie społeczeństwo, jak i specjalistów zajmujących się energetyką odnawialną, propagacją zanieczyszczeń czy zagrożeniami pożarowymi. Dodatkowo zaangażowaliśmy się we współpracę z miłośnikami astronomii, publikujemy prognozy dla ciekawych zjawisk astronomicznych. Wielokrotnie w czasopiśmie „Urania – Postępy Astronomii” ukazywały się nasze opracowania. Tych różnych zagadnień pojawiło się bardzo dużo, rozwijamy je, budują one nasze portfolio. W ten sposób pokazujemy, że w CMM zajmujemy się nie tylko stricte modelami, ale potrafi je praktycznie wykorzystać.

Mocno postawiliśmy na edukację, podpowiadamy, jak racjonalnie wykorzystywać nasze modele. Jeżeli ktoś poprzez media społecznościowe zadaje nam pytania, zawsze staramy się odpowiedzieć. Opisy różnego rodzaju zjawisk publikujemy na naszej stronie w zakładce #AkademiaCMM.

Ile osób pracuje w CMM?

W momencie, kiedy centrum startowało, liczyło 23 pracowników. Teraz jest 39 osób. Ten wzrost jest jednak ściśle powiązany ze zwiększaniem liczby zadań, za które odpowiada CMM. Wspomnę tylko, że w ciągu tych kilku lat od powstania CMM przejęliśmy operacyjną produkcję danych do Polskiej Agencji Żeglugi Powietrznej, tych wszystkich parametrów pogodowych dla osłony lotnictwa i lotnisk niezbędnych dla synoptyków, czy też osłonę meteorologiczną lotnisk Ukrainy. Dostarczamy dane dla naszych synoptyków i hydrologów oraz wielu odbiorców publicznych i komercyjnych.

CMM w całości ulokowane jest w Warszawie?

W Warszawie mieści się główna siedziba, tutaj też znajdują się zakłady Prognoz Numerycznych COSMO oraz Analiz Meteorologicznych i Prognoz Długoterminowych, którym kieruje absolwentka kierunku geodezja i kartografia dr inż. Marta Gruszczyńska. Jest też ona moim zastępcą, a zatem można powiedzieć, że Centrum Modelowania Meteorologicznego w IMGW-PIG kieruje dwoje geodetów. Zakład Prognoz Numerycznych ALADIN mieści się w Krakowie, a Zakład Nowcastingu – w Katowicach. Poza tym pojedyncze osoby w naszym centrum pracują z Wrocławia, Poznania i Gdyni.

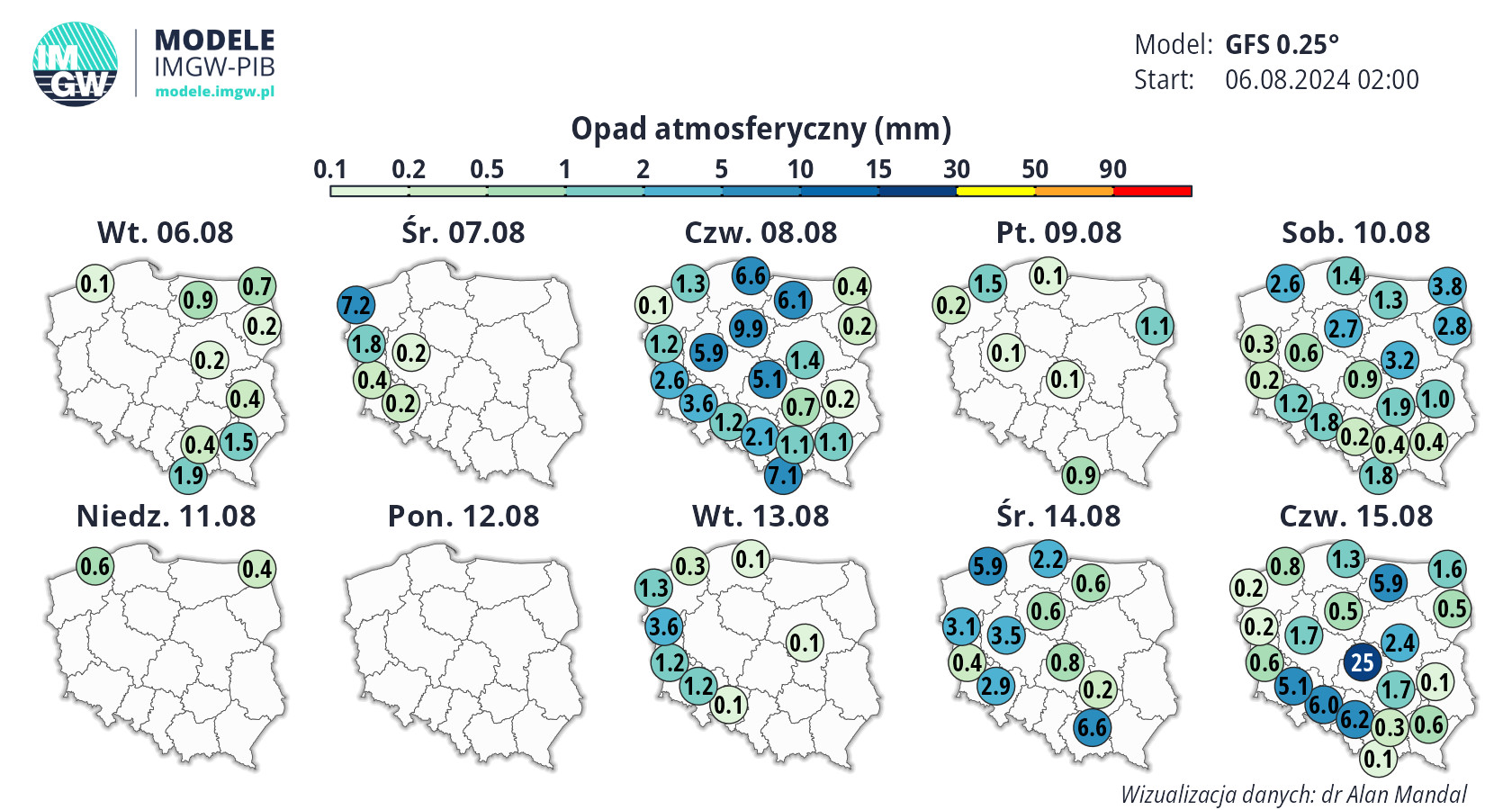

Prognoza średnioterminowa – opady

Ma pan trudności ze znalezieniem nowych pracowników?

Środowisko specjalistów od modelowania jest bardzo małe. Przede wszystkim brakuje kluczowych w modelowaniu ekspertów od fizyki atmosfery. W Polsce takich specjalistów kształci w zasadzie tylko Uniwersytet Warszawski. Dlatego też musieliśmy ściągnąć w ramach projektów do CMM dwie osoby z zagranicy, co nie było proste ze względu na różnice w pensjach u nas i w Europie Zachodniej.

W ubiegłym roku, z czego jestem niezmiernie dumny, udało mi się podpisać porozumienie o współpracy ze stowarzyszeniem Polscy Łowcy Burz. Jego członkowie to nie tylko pasjonaci, którzy od lat jeżdżą po Polsce w ślad za ekstremalnymi zjawiskami pogodowymi, ale też nierzadko osoby wykształcone na kierunkach związanych z klimatologią czy meteorologią. Dzięki temu porozumieniu m.in. mam możliwość pozyskania bardzo ciekawych i merytorycznych osób do pracy w CMM.

Jacy specjaliści znajdują zatrudnienie w centrum?

Oprócz wspomnianych już fizyków atmosfery: geografowie, bo dziś w Polsce tylko na kierunku geografia kształci się specjalistów od klimatologii i meteorologii, matematycy, informatycy, a także geodeci. Wśród obecnych pracowników są osoby zaraz po studiach, w średnim wieku z wykształconą już wizją naukową, a także specjaliści, którzy całe życie naukowe spędzili w instytutach badawczych związanych z meteorologią, w tym za granicą na różnego rodzaju stażach.

Dla mnie najistotniejsze jest to, aby ludzi w CMM charakteryzowała pasja, bo wiedzę można uzupełnić. U nas w centrum mamy system wewnętrznego dokształcania, przekazywania wiedzy młodszym pracownikom przez tych starszych i bardziej doświadczonych. Poza tym staram się organizować różnego rodzaju kursy, także komercyjne, przede wszystkim informatyczne. Bo u nas informatyka jest narzędziem bezwzględnie potrzebnym. Nie wystarczy coś wymyślić, trzeba też wiedzieć, jak to zakodować. Poza tym w naszej pracy bazujemy głównie na superkomputerach. Do tego dochodzi jeszcze programowanie równoległe, chyba najbardziej zaawansowane i skomplikowane zagadnienie, jeżeli chodzi o przetwarzanie dużej ilości danych, a także sztuczna inteligencja i algorytmy głębokiego uczenia maszynowego. Są to technologie, które stosujemy od dawna, nim stały się powszechnie modne.

Mógłby pan coś więcej powiedzieć o geodetach w CMM?

Zacznę od tego, że do tworzenia numerycznych modeli pogody wykorzystujemy elementy stricte geodezyjne, jak numeryczne modele terenu czy informacje o formach użytkowania terenu. Poza tym w CMM opracowujemy przecież mapy, które muszą mieć georeferencję – w tym odnajdują się kartografowie. Przyznam, że kiedy na początku pracy w IMGW zacząłem przyglądać się tworzonym tu wizualizacjom różnych parametrów pogodowych, prawie zapłakałem – nic z tego nie byłem w stanie zrozumieć. Każdy model to była inna prezentacja, inne kolory, inna skala. Wówczas zacząłem dociekać, czy w meteorologii obowiązują jakieś standardy z tym związane. Okazało się, że nie. Dlatego też, żeby usprawnić działanie w instytucie, wprowadziłem zunifikowany system wizualizacji meteorologicznej oparty na fundamentach kartograficznych. Postawiłem na prostotę przekazu, jeden parametr na jednej mapie, żadnych zbędnych informacji, które nie są potrzebne przeciętnemu użytkownikowi, te same reguły dla wszystkich modeli, barwy dobrane tak, by oddawały charakter danego parametru. To, co teraz możemy zobaczyć na stronach CMM, jest wynikiem tej pracy. Ja opracowałem założenia, zbudowałem cały silnik, a moi współpracownicy z centrum pociągnęli to dalej, implementowali do kolejnych modeli. Tych wszystkich prac nie udałoby się zrealizować bez wiedzy i doświadczeń z zakresu geodezji i kartografii – mojego i moich koleżanek i kolegów z CMM.

Ponadto zaczęliśmy tworzyć mapy dla osób z problemem rozpoznawania barw. Na razie przygotowaliśmy opracowania dla temperatury i wilgotności, i, co istotne, spotkały się one z pozytywnym odbiorem użytkowników z zaburzeniami widzenia barw.

Z naszej rozmowy wynika, że centrum to nie tylko modelowanie.

W CMM realizujemy wiele zróżnicowanych zadań. Stąd też każdy pracownik znajdzie coś dla siebie. Albo powiem inaczej – dla każdego znajdę jakąś pracę zgodną z jego kompetencjami, ale muszą być one wysokie. Oczywiście nikogo do niczego nie przymuszam. Staram się być bardzo elastyczny, rozmawiam, dopasowuje powierzane zadania do predyspozycji czy zainteresowań. Bo nie każdy przecież jest wirtuozem programowania czy pracy koncepcyjnej. W ten sposób się uzupełniamy i jeżeli zaczniemy pracować nad jakimś problemem, to jest 90% szans na sukces. Co warte podkreślenia, pracownicy CMM są otwarci nie tylko na pomysły związane z modelowaniem. Za przykład mogą posłużyć prognozy animowane, projekt jeszcze nie dokończony, bo marzy mi się do nich dobry podkład muzyczny, czy „Sztuka upału” – przygotowany przez naszą koleżankę z zespołu katalog łączący dzieła sztuki z rekomendacjami na upalne dni. Wydaje mi się, że wypracowaliśmy w CMM bardzo ciekawy model, który przede wszystkim daje satysfakcję ludziom pracującym w centrum.

Co pan uznaje za największy sukces CMM?

Pojawienie się CMM w obiegu zewnętrznym. Centrum stało się widoczne zarówno w portalach internetowych, jak i w mediach społecznościowych, staliśmy się zespołem opiniotwórczym. Przyjęły się nasze wizualizacje, mapy, sposób prezentacji pogody czy, ogólnie rzecz biorąc, danych pomiarowych. Na początku, jak wpisywałem „Centrum Modelowania Meteorologicznego” w wyszukiwarkę internetową i zaznaczałem „Ostatnie 24 godziny”, to wyskakiwał jeden wpis albo wcale. Teraz są to co najmniej trzy strony wpisów. To ogromny sukces, społeczeństwo i media wreszcie postrzegają nas jako ekspertów. Odkąd rozpocząłem pracę w IMGW przekonałem przynajmniej część współpracowników, że muszą się wypowiadać w mediach, informować o rzeczach, które robimy. Musimy pokazywać, że pieniądze, które podatnicy płacą na nasze pensje, nie są marnowane. Dlatego też opowiadamy o pogodzie, rządzących nią mechanizmach, jak np. w audycji „Patronautyka” Radia 357 czy podcastach internetowych. Staramy się łagodzić negatywne przekazy, których teraz niemało w mediach, ostrzegać, ale nie straszyć.

Kiedyś IMGW uchodził za jednostkę bardzo zamkniętą. Dlatego też zależało mi na pewnym nowym otwarciu. Nowe centrum, nowe podejście i nowy przekaz. Uruchomiona nie tak dawno strona meteo.imgw.pl powstała z pewnych doświadczeń CMM. Mój zespół ją zaprojektował, pokazał, że można przedstawić informacje w jasny sposób. Otrzymaliśmy wiele maili z podziękowaniami za tę stronę, co bardzo nas cieszy, bo przecież jesteśmy służbą hydrometeorologiczną kraju i robimy to wszystko dla społeczeństwa.

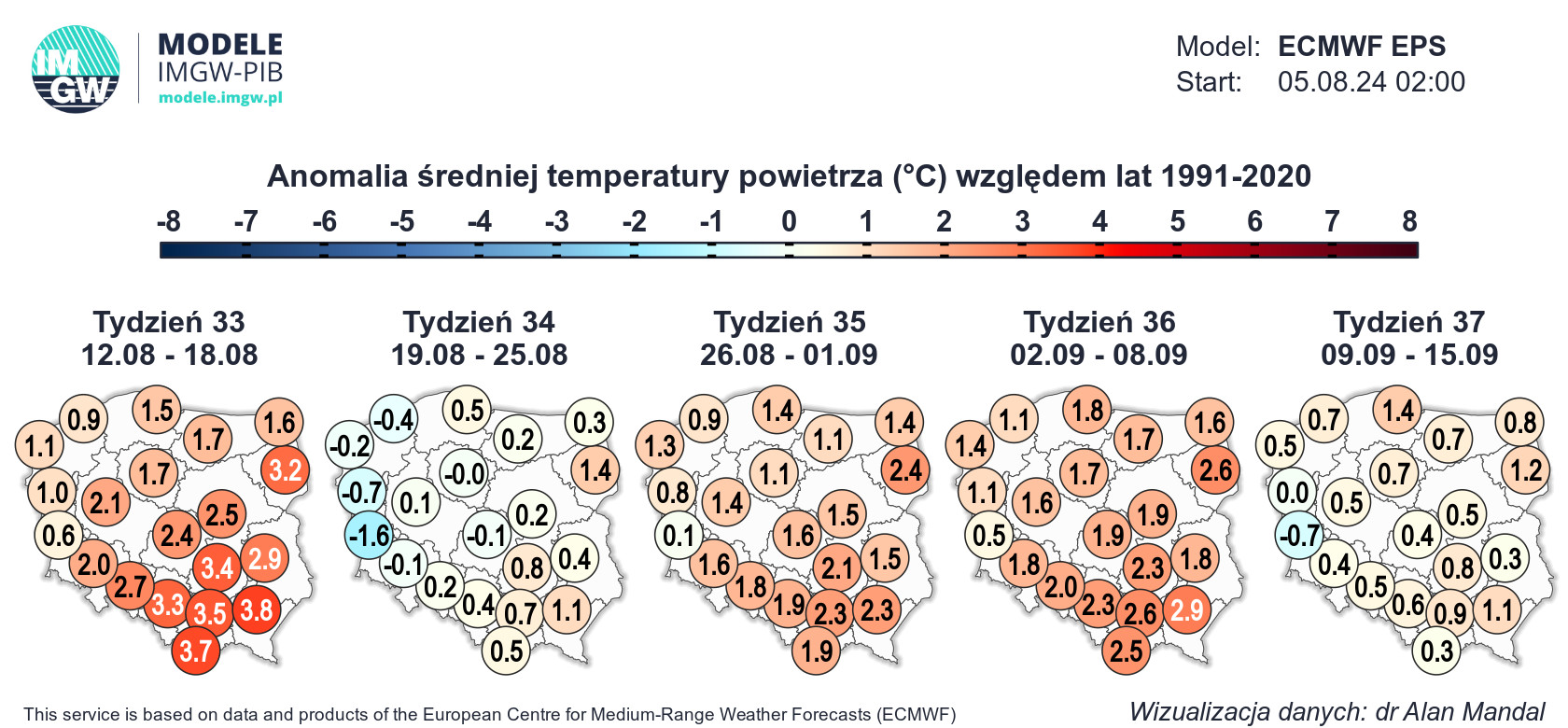

Prognoza długoterminowa – temperatura

A przed jakimi wyzwaniami stoi teraz CMM?

Na ten rok największe wyzwanie to przeniesienie całej produkcji na nowe superkomputery w Warszawie i Krakowie. Będzie to trwało kilka miesięcy i rozpocznie się we wrześniu. Zyskamy w ten sposób dodatkowy ośrodek umożliwiający działanie w przypadku jakiejkolwiek awarii.

Kolejne wyzwanie to wdrożenie sztucznej inteligencji na szeroką skalę. Już to powoli robimy, na początek tworzymy mały zespół specjalistów od AI składający się głównie z fizyków, matematyków i informatyków. AI, które działa na zasadach analogii, może znacznie przyspieszyć prognozy, bardzo dobrze radzi sobie w modelach klimatycznych, których większość to modele probabilistyczne, a więc już z samego założenia działające na pewnych statystycznych uwarunkowaniach i danych. Dalej – sztuczną inteligencję można zastosować, zresztą już się to robi, w parametryzacji modeli. Mam tu na myśli bardzo skomplikowane obliczenia związane z fizyką promieniowania czy fizyką gleby.

Domyślam się, że to nie wszystkie plany.

Brakuje w tym wszystkich jeszcze modelowania klimatu, którego na razie nie ma instytucie, ale również w Polsce. Dlatego moim marzeniem jest powołanie nowego zespołu fizyki i modelowania klimatu. Kto mnie zna, wie, że jestem niecierpliwym człowiekiem, dlatego już od roku pracujemy nad implementacją modeli klimatycznych w ramach projektów obliczeniowych w CI TASK na Politechnice Gdańskiej i przystąpiliśmy do inicjatywy EURO-CORDEX. W Polsce do tej pory nikt tego nie robił, a scenariusze klimatyczne są bezwzględnie potrzebne dla gospodarki i z punktu widzenia zagadnień związanych z adaptacją do zmian klimatu. Obecnie musimy wykorzystywać dane z różnych zagranicznych ośrodków, które nie są przygotowywane stricte dla naszego kraju.

Przygotowywanie modeli klimatycznych to zadanie bardzo czasochłonne, bo nim zostaną uruchomione, muszą przeanalizować ogromną ilość danych archiwalnych. Obecnie granicą scenariuszy jest zazwyczaj 2100 r. Wówczas standardem jest sięganie po dane od 1949 r. Jak wyliczyłem, przy optymistycznych założeniach, taki model będzie liczony około roku. W tej chwili przygotowujemy dwa modele klimatyczne, w zasadzie przez ostatnich pięć miesięcy głównie nad nimi pracowałem.

Dodatkowo zastanawiamy się nad modelami klimatycznymi wysokiej rozdzielczości – rzędu trzech lub czterech kilometrów. Szukamy odpowiedzi na pytanie, czy byłyby one w stanie przewidzieć zjawiska ekstremalne. Wcześniej nikt nie analizował modeli klimatycznych od tej strony i w tej skali. Oprócz nas próby podejmuje Francja i Niemcy, ale w zdecydowanie większych zespołach.

Wyzwania, które nas czekają, są zatem naprawdę potężne. Poza tym musimy pozostawać otwarci, na to, co przyniesie przyszłość, reagować na wszelkie wydarzenia, które mogą wiązać się z zapotrzebowaniem na dane meteorologiczne, zarówno pomiarowe, jak i najbardziej modelowe.

Mimo tych wszystkich obowiązków znajduje pan jeszcze czas na pracę na uczelni.

Tak, ciągle wykładam na Politechnice Gdańskiej i trudno byłoby mi przestać. Prowadzę przedmiot geodezja satelitarna i wydaje mi się, że robię to całkiem nieźle. Staram się zawsze przedstawiać temat szerzej aniżeli zrobiliby to geodeci z wykształcenia. Pokazuję, że geodezja w tej chwili to bardzo specyficzna i ciekawa nauka, która jest na usługach wielu innych dyscyplin, dająca różnego rodzaju uniwersalne narzędzia i rozwiązania możliwe do zastosowanie wszędzie. Jeżeli ktoś poświęci te lata na uczelni na faktyczne studiowanie i inwestowanie w siebie, to pracę znajdzie nie tylko w geodezji, ale w wielu sektorach gospodarki.

Na swoich zajęciach dużą uwagę zwracam też na komunikację, sposób wypowiadania się. Dla mnie to niezwykle ważne. Opracowanie czegoś to jedno, później trzeba to jednak zaprezentować, sprzedać. Nie raz przekomarzam się ze studentami i czepiam o słówka, ale czasem w dyskusjach to właśnie te słówka grają rolę, a nie cały kontekst, o którym się opowiada. Wówczas wyczuwa się, na ile człowiek orientuje się w danym temacie i rozumie go.

Ja sam z wykształcenia jestem automatykiem, studiowałem też fizykę. Później miałem okazję pracować i robić doktorat w Instytucie Geodezji Wyższej i Astronomii Geodezyjnej Politechniki Warszawskiej. Dodatkowo od lat 2000. zacząłem się bawić numerycznymi modelami pogody. Całe to wykształcenie i zdobyte doświadczenie pozwoliło mi odnaleźć się w IMGW. Praca tutaj niesie za sobą wiele wyzwań, daje mi możliwość wyżycia się zarówno naukowego, jak i organizacyjnego. Przede wszystkim jednak staram się być mentorem i nauczycielem młodych adeptów trudnej sztuki modelowania meteorologicznego.

Wraca pan czasem myślami do okresu studiów i doktoratu?

Bardzo miło wspominam lata studiów, a później pracy na WAT i PW. IGWiAG mnie ukształtował. Kiedyś to był filar Wydziału Geodezji i Kartografii Politechniki Warszawskiej. Poznałem tam wielu wspaniałych ludzi. Profesorowie Śledziński, Barlik, Czarnecki, Rogowski to klasycy geodezji fizycznej. Tam właśnie było to, o czym już dziś opowiadałem – pasja. Mogę powiedzieć, że kiedyś miałem okazję stanąć na barkach olbrzymów. Ktoś zauważył mnie i pomógł, i teraz ja czuję się zobowiązany, by pomagać innym. Szczególnie w IMGW i w Katedrze Geodezji Politechniki Gdańskiej, gdzie obecnie pracuję.

nadchodzące wydarzenia

nadchodzące wydarzenia

zobacz pozostałe

zobacz pozostałe